Können FPGAs GPUs bei der Beschleunigung von Deep Neural Networks der nächsten Generation übertreffen?

Globaler Lieferant elektronischer Komponenten AMPHEO PTY LTD: Umfangreiches Inventar für One-Stop-Shopping. Einfache Anfragen, schnelle, individuelle Lösungen und Angebote.

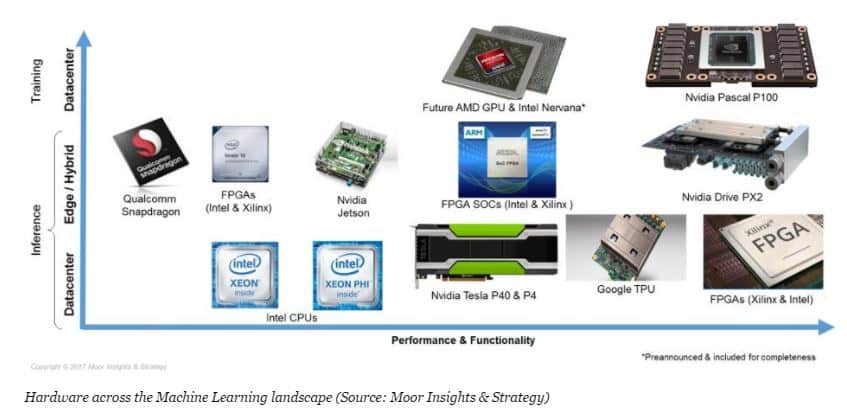

Ob FPGAs (Field-Programmable Gate Arrays) GPUs (Graphics Processing Units) bei der Beschleunigung von Deep Neural Networks (DNNs) der nächsten Generation übertreffen können, hängt von mehreren Faktoren ab, darunter der spezifische Anwendungsfall, der Typ des neuronalen Netzwerks, die Energieeffizienz und die Arbeitslast. Beide Technologien haben einzigartige Stärken und Schwächen, die sie für unterschiedliche Szenarien geeignet machen.

Stärken von FPGAs bei der Beschleunigung von DNNs

1. Anpassbare Hardware:

- FPGAs ermöglichen eine feingranulare Anpassung der Hardwarearchitekturen an spezifische Workloads von neuronalen Netzen.

- Optimierungen wie reduzierte Präzisionsarithmetik (z.B. INT8, INT4) und benutzerdefinierte Datenflüsse können die Leistung erheblich verbessern.

2. Energieeffizienz:

- FPGAs sind oft energieeffizienter als GPUs, da sie unnötigen Overhead vermeiden und für spezifische Aufgaben optimiert werden können.

- Besonders geeignet für Edge-Geräte oder Rechenzentren mit strikten Energieanforderungen.

3. Geringe Latenz:

- FPGAs bieten eine geringere Inferenzlatenz, da sie nicht so stark auf Batch-Verarbeitung angewiesen sind wie GPUs.

- Ideal für Echtzeitanwendungen (z.B. autonome Fahrzeuge, Robotik, Edge-AI).

4. Flexibilität:

- FPGAs können sich an neue Architekturen und Workloads anpassen, ohne dass neue Hardware erforderlich ist.

- Besonders geeignet für experimentelle oder schnell wachsende Modelle.

Stärken von GPUs bei der Beschleunigung von DNNs

1. Parallele Verarbeitungsleistung:

- GPUs sind für massive Parallelverarbeitung ausgelegt, was gut zu den Matrix- und Tensorberechnungen passt, die in DNNs häufig vorkommen.

- Optimierte Bibliotheken wie cuDNN und TensorRT von NVIDIA bieten umfassende Softwareunterstützung.

2. Entwicklungsökosystem:

- GPUs verfügen über ein ausgereiftes Software-Ökosystem, mit etablierten Frameworks (z.B. PyTorch, TensorFlow), die für GPU-Beschleunigung optimiert sind.

- Einfacher für Entwickler, KI-Modelle auf GPUs zu integrieren und bereitzustellen.

3. Höherer Durchsatz für große Modelle:

- Bei groß angelegten Trainingsaufgaben (z.B. GPT-Modelle) übertreffen GPUs FPGAs in der Regel aufgrund ihrer enormen Rechenleistung.

- GPUs sind besser für große Batch-Größen geeignet.

4. Benutzerfreundlichkeit:

- GPUs sind für KI-Forscher und Entwickler leichter zugänglich, dank standardisierter Tools, vorgefertigter Bibliotheken und Community-Support.

Wann können FPGAs GPUs übertreffen?

- Spezialisierte Architekturen: Workloads, die von spezialisierter Hardware profitieren (z.B. spärliche neuronale Netze, Transformer-Architekturen mit neuartigen Aufmerksamkeitsmechanismen).

- Kleine Batch-Größen: Echtzeit-Inferenz mit minimalen Batch-Anforderungen.

- Energieeinschränkungen: Edge-AI-Anwendungen mit strikten Energie- oder Wärmelimits.

- Neue Modelle: Experimentelle DNN-Architekturen, die noch nicht für GPU-Bibliotheken optimiert sind.

Wann sind GPUs besser als FPGAs?

- Training großer Modelle: GPUs sind unschlagbar beim Training groß angelegter Modelle und Szenarien, die hohen Durchsatz erfordern.

- Etablierte Frameworks: Workloads, die mit bestehenden Softwarebibliotheken wie TensorFlow und PyTorch übereinstimmen.

- Schnelles Prototyping: Schnellere Entwicklungs- und Bereitstellungszyklen dank ausgereifter Software-Ökosysteme.

Hybrider Ansatz: Die Zukunft der KI-Beschleunigung?

Viele Organisationen untersuchen hybride Architekturen, bei denen GPUs für große Trainingsaufgaben eingesetzt werden, während FPGAs für Inferenz oder spezialisierte Edge-AI-Aufgaben verwendet werden. Zum Beispiel:

- GPUs für das Modelltraining

- FPGAs für Echtzeit-Inferenz auf Edge-Geräten

Fazit

- FPGAs glänzen bei geringer Latenz, Energieeffizienz und anpassbaren Architekturen.

- GPUs dominieren bei hohem Durchsatz, großen Batch-Größen und etablierten Frameworks.

In Zukunft wird die Wahl zwischen FPGAs und GPUs von den Anforderungen der Arbeitslast, den Einsatzbedingungen und dem Gleichgewicht zwischen Flexibilität, Leistung und Energieeffizienz abhängen.

Verwandte Artikel

- ·Anwendung von Differenzkristalloszillatoren auf Hochgeschwindigkeits-FPGAs

- ·Wie funktioniert JTAG bei FPGAs?

- ·Wie werden FPGAs in AI/ML Anwendungen eingesetzt?

- ·Anwendung von Embedded Systems in Industrierobotern

- ·Was ist der Unterschied zwischen Zybo-Boards und FPGAs? Und wann werden sie verwendet?

- ·Was sind die am häufigsten verwendeten Chips in der Embedded-Entwicklung?

- ·Diskussion über die Anwendung von FPGA in der Videokodierung